正しいビデオキャプチャシステムの見つけ方

カメラ、スイッチャーを選択し、ステージングを計画しました。次に、ビデオ制作をキャプチャーするためのインジェストソリューションを選択する必要があります。このガイドでは、ビデオキャプチャソリューションを決定する際に考慮すべきポイントを説明します。

ショートカット

- IP、NDI、SRTのサポート

- ストリーミング形式のサポート

- Capture2Cloud - クラウドへの直接インジェスト

(I) 生産ワークフローの目標

ビデオレコーダーを選ぶ際には、ワークフローの目的を考慮する必要があります。例えば、ライブ・ストリーミングに近い形で録画するのか、あるいは、次のような迅速な放送のために録画するのか。 礼拝堂? また マルチカムスタジオプロジェクト最終的な出力に何週間もかかるようなスタジオ・プロジェクトの収録ですか?あるいは、編集されずにそのまま アーカイブ?

ビデオメーカーには、マルチカメラ撮影プランニングのための素晴らしいガイドがあります。チェックする こちら.

ワークフローの目的を定義しよう:

i) ニア・ライブ・ブロードキャストまたはストリーミング

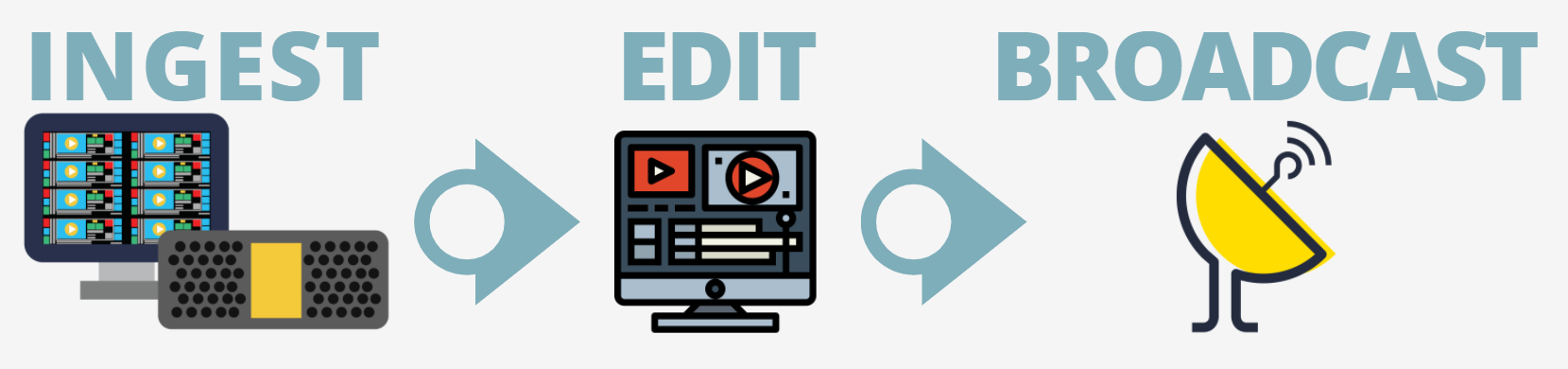

生放送に近い形で ニア・ライブ・ブロードキャスト ワークフローのシナリオでは、ディレクターやプロデューサーがスイッチャーを使って複数のカメラのラインカットを作成します。収録されたラインカットは、Adobe After EffectsやMedia Composerなどの編集ソフトに取り込まれ、グラフィックやタイトルが追加されます。このファイルをエクスポートしてストリーミングに使用する。納期は通常30分以内なので、ここで編集が行われることはほとんどありません。

ii) 編集のための録音

スタジオでの マルチカメラ・スタジオ収録マルチカメラスタジオ収録では、スタジオセットやステージ上で複数のカメラを使って番組を収録します。典型的な収録シナリオは、3台のアイソレートまたは "ISO "カメラと1台のラインカット、合計4つの収録チャンネルです。前のワークフローで説明したように、ディレクターまたはプロデューサーは、編集チームの基準となるラインカット収録を指示します。

iii) アーカイブへの記録

科学的環境 科学環境や監視環境ではこのようなマルチカメラ録画の最終目的はアーカイブである。このようなマルチカメラ録画の最終目的はアーカイブである。コーデックとラッパーに関する検討は、選択したフォーマットのサポートの寿命という固有の問題があるため、重要な作業である。

(II) インジェスト・ソリューションで考慮すべき機能

いくつかの 必須機能があります。最も重要なことは、キャプチャーシステムが以下を可能にすることです。

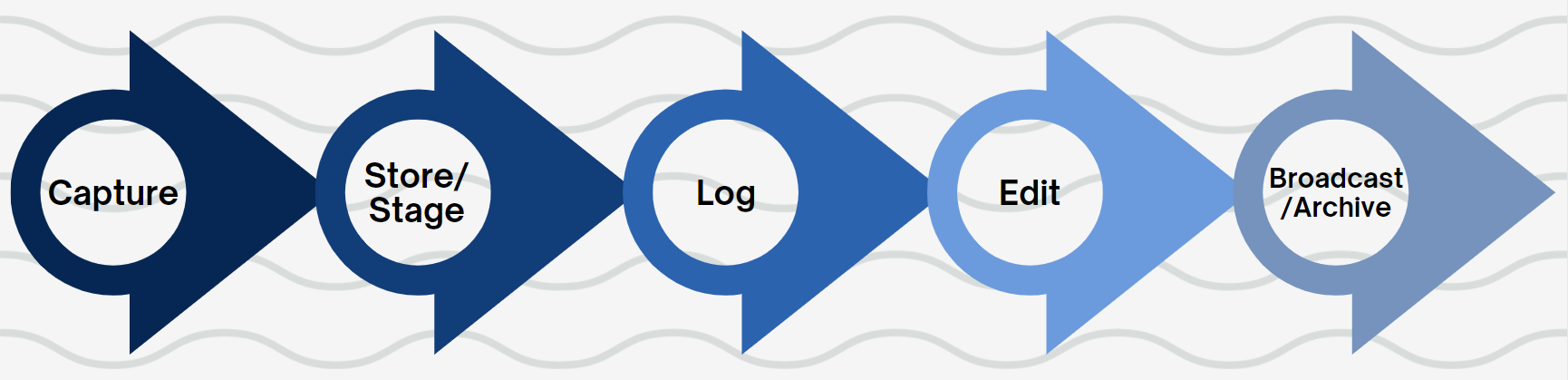

F-L-O-W プロダクションからポスト、アーカイブまで.以下は、検討すべきいくつかのポイントです。

i) 使いやすさ/セットアップの容易さ:

理想を言えば、プラグ&プレイ・デバイスが望ましい。つまり、ソースを接続すれば、ダウンタイムやトレーニングを最小限に抑えながら、すぐにレコーディングを開始できるということだ。

ii) ギャング・コントロール

すべての記録チャンネルでタイムコードを一致させることは、マルチカメラの記録セッションで最低限必要なことです。これは、外部トリガーによる全チャンネルのギャング制御、または記録システム内にこの機能がある場合は内部制御で実現できます。映像制作の規模にもよりますが、数十から数百、数千のファイルをポストポストへ送ったり、再生のためにレビューしたりすることがあります。すべてのチャンネルで同じタイムコードは、編集や再生のための重要な基準点となります。

iii) フレキシブル・ファイル・ネーミング

ファイル名は、編集プロセスの重要なメタデータとして機能します。例えば、毎日の子供番組を録画している場合、ファイル名に含まれる有用な情報には、人形の名前、タレントの名前、シーンとテイク番号などが含まれるでしょう...この情報は、編集者がシーケンスを編集する際に有用なリファレンスとなります。

iv) 生産からポストへの流れ

もうひとつ考慮すべきことは、遅延を最小限に抑えるためにできることである。 最小限の遅延録音素材の遅延やミスを最小限にするために、あなたが取ることができる手順です。 制作からポストまで.以下は、あなたが考慮すべき項目です。

- ネットワーク録画:

- ネットワーク宛先に直接録画することで、例えばセット上のカメラカードから別の場所にメディアを転送するダウンタイムがなくなります。3つのISOと1つのLinecutの典型的なマルチカムシナリオで8時間以上のメディアを録画した場合、32時間のメディアを別の場所にコピーする必要があります。データコピーの全プロセスには、簡単に数時間以上かかることがあります!

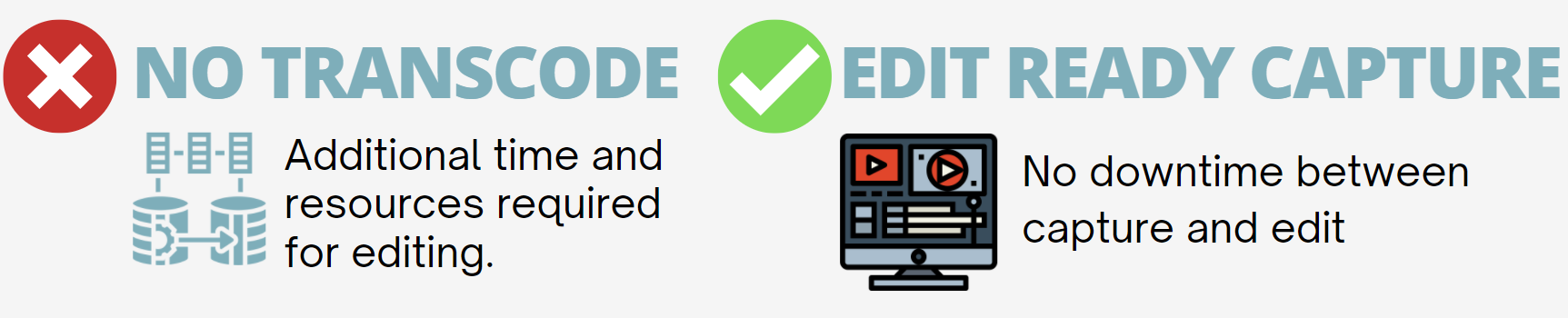

- 編集可能なフォーマット

- オンカメラレコーダーやスタンドアロンレコーダーは、ポストプロダクションが編集に必要とするファイルタイプを作成できないため、トランスコーディングはマルチカムワークフローの典型的な部分だった。これは古いパラダイムだ。現在では、多くのレコーダーが編集準備の整った素材を作成できるため、ポストプロダクションでトランスコードするための追加のステップは必要ありません。

- プライマリ/プロキシファイルの作成

- 4K番組はあなたの最終目標かもしれない。しかし、4Kファイルで編集することは、システムリソースを大量かつ不必要に消費する可能性があります。代わりに、H.264などのプロキシファイルで編集しましょう。そして、編集、カラー、VFXが完了したら、4Kファイルにマッチバックしてください。

- レコードの冗長性

- 規模の大小にかかわらず、プロダクションへの投資は保護したいものです。素材のバックアップコピーを別の場所に同時に作成できるシステムを使用することは、プロダクションの成功に不可欠です。

v) RESTFUL API

- 相互運用性は、スムーズなワークフローを生み出す鍵です。RESTfulなAPIは、どの製品も他の製品を制御し、統合できることを保証します。

(III) 生産ターンタイム

プロダクションの種類によっては、収録した素材をすぐに利用できるようにする必要があるかもしれません。例えば、編集した素材をライブに近い状態で放送する必要がありますか?(例:収録開始から30分)。ここでは、迅速な納期を必要とするプロダクションのために考慮すべき戦略をいくつかご紹介します。

i) 録音編集準備フォーマット

前述したように 編集可能な素材をキャプチャするをキャプチャすることで、トランスコードに必要な時間がなくなります。録画が停止すれば、ファイルはすぐに編集できる状態になります。

ii) WHILE CAPTUREの編集

このレコードスタイルでは、ファイルの成長中に編集することができます。通常、特定のコーデック、ラッパーでのみ利用可能で、サポートはNLEによって異なります。例えば、Op1A MXFラッパーを使用したXDCAMをAdobe Premiereで編集する場合、キャプチャしながら編集するワークフローが一般的です。Premiereは編集タイムラインを自動更新するので、編集可能な新しい素材を見ることができる。このワークフローの欠点は、ファイルの整合性を保つことです。複数の人間がシーケンスを編集する場合、ファイル自体が破損する可能性がある。このような問題を避けるためには、ポストプロダクション・チームと調整することが重要だ。

iii) セグメント記録

時には、監視やリアリティーのような記録的なシナリオもある。 リアリティ番組不特定多数の時間を録画することがある。その結果、何時間ものファイルになる可能性があり、扱いにくく、破損しやすくなります。 このリスクを相殺するために、セグメント記録(チャンキング)と呼ばれる記録スタイルを使うことができる。30分になると、現在のセグメント(ファイル)は閉じられ、新しいファイルがフレームを落とすことなくシームレスに開かれる。クローズされたセグメントは、安全に編集、ストリーミングなどが可能だ。

(IV) ポストプロダクション

大半のプロダクションにとって、最終的なゴールは編集されたシーケンスを作成することである。ディレクターが "カット!"と叫んでも、制作は終わらない。むしろ、編集に渡された素材は、編集、色彩、VFXのプロセスを通じて物語へと変化していく。

大半のプロダクションにとって、最終的なゴールは編集されたシーケンスを作成することである。ディレクターが "カット!"と叫んでも、制作は終わらない。むしろ、編集に渡された素材は、編集、色彩、VFXのプロセスを通じて物語へと変化していく。

ポストプロダクションへのハンドオフを可能な限りスムーズに行うために、プロダクション・プランニングはポストプロダクションのワークフローに関する計画を折り込む必要がある。 ここでは、ポストプロダクション・チームと話し合う必要がある項目をいくつか紹介する。

i) 編集ソフトウェア

特定のコーデックとラッパーは、特定の編集ソフトウェアに適しています。例えば、編集ソフトウェアとしてAvid Media Composerを使用する場合、ポストプロダクションに配信するファイルタイプは、AvidネイティブラッパーであるMXF OpAtomになります。このファイルタイプが収録中に作成されない場合、トランスコードする必要があり、不必要なダウンタイムが発生します。

ii) ポスト・プロダクションで要求されるコーデック

一般的に、どの編集ソフトも、いくつものファイルタイプやラッパーをうまく扱うことができる。つまり、編集や再生のためにファイルを移動させても、ラグが最小限に抑えられるのだ。しかし、このケースには例外もある。例えば、XAVCの再生にはシステムリソースを大量に消費するデコードが必要で、編集システムにラグやストールを発生させるため、XAVCは移動が難しいコーデックです。したがって、ポストプロダクションに配信するには理想的なコーデックとは言えない。

iii) 最終ファイルをどのような解像度で提出しますか。

もし 配信解像度が4Kの場合4Kを配信解像度とする場合、プライマリレコード解像度を4K以上で記録すると同時に、それにマッチするプロキシフォーマットも記録する必要があります。プロキシフォーマットは、高解像度ファイルとタイムコードが一致する軽量HD H.264、DNxHD 36、またはProRes Proxyでも構いません。プライマリファイルとプロキシファイルのタイムコードが一致するため、最終的なコンフォーム時に、高解像度ファイルは編集素材にマッチバックします。

(V) ワークフローを将来にわたって維持するには?

ビデオ制作は何度か技術革命を経験しており、そのたびに変化の波は短い間隔で訪れている。10年前に採用されたワークフローは時代遅れである可能性が高いが、利害関係者はうまくいっているプロセスを革新したがらないため、サイロ的な考え方が生まれ始める可能性がある。

ビデオ制作は何度か技術革命を経験しており、そのたびに変化の波は短い間隔で訪れている。10年前に採用されたワークフローは時代遅れである可能性が高いが、利害関係者はうまくいっているプロセスを革新したがらないため、サイロ的な考え方が生まれ始める可能性がある。

i) I/Oの新しいIP信号のサポート

コンピューティングパワーとネットワーク/インターネット帯域幅の進歩により、特にアップロード側では、標準的なIPプロトコルを使用して、プライベートIPネットワークやインターネット上でデジタル化されたビデオストリームを圧縮して送信することが可能になり、ビデオは利用可能な帯域幅に合わせて異なるデータレートに調整することができます。

IPベースのビデオは、IP接続環境内の各マシンをスタンドアロン・ソースとして、またソースのスイッチボードとして機能させることができる。すべてのライブ・ストリーミング・ソースは、IPビデオ環境に接続されたどのマシンでも、他のライブ放送にカットインすることができる。 これにより、ロケ先のユーザー・デバイスからのライブ・ストリームなど、従来のソースとそうでないソースの両方を使用したコラボレーションやコンテンツ制作の可能性が大きく広がります。

同じIPインフラを使って、老朽化したSDI設備をコモディティ・ハードウェアとソフトウェアベースのツールで置き換え、従来のスイッチング、ルーティング、モニタリング機器を置き換えることができる。 以下のようなプロトコル SMPTE-2110 や NDIなどのプロトコルはを提供します。 NDIは実装がはるかにシンプルですが、SMPTE-2110はSDIをより洗練されたものに置き換えたもので、各エッセンスを独自の、個別に利用可能なストリームとして分割します。

ii) ストリーミング形式のサポート

ソーシャルメディアやリモートワークのアプリケーションが普及するにつれ、コンテンツの直接ストリーミングと、入力されるストリーミングフィードの録画の両方がますます重要になってきている。

人気を集めている信号フォーマットは SRTハイビジョン社が開発したオープンソースのトランスポート・プロトコルである。スタジオや施設は、既存のネットワーク・インフラを活用して、ビデオ信号をポイント・トゥ・ポイントで記録することができ、従来の高価な衛星伝送に取って代わることができる。新しく高価なインフラを必要としないため、SRTは新しい施設やアップグレードで支持され続けている。